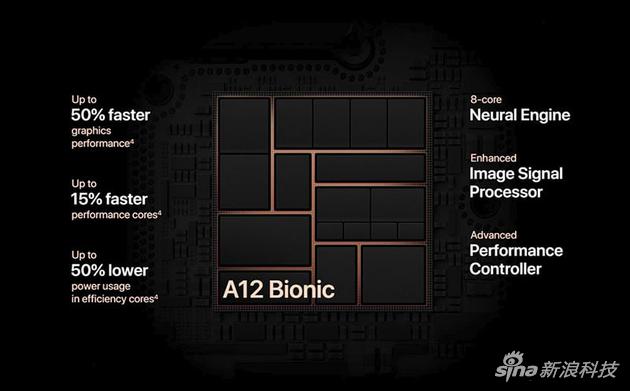

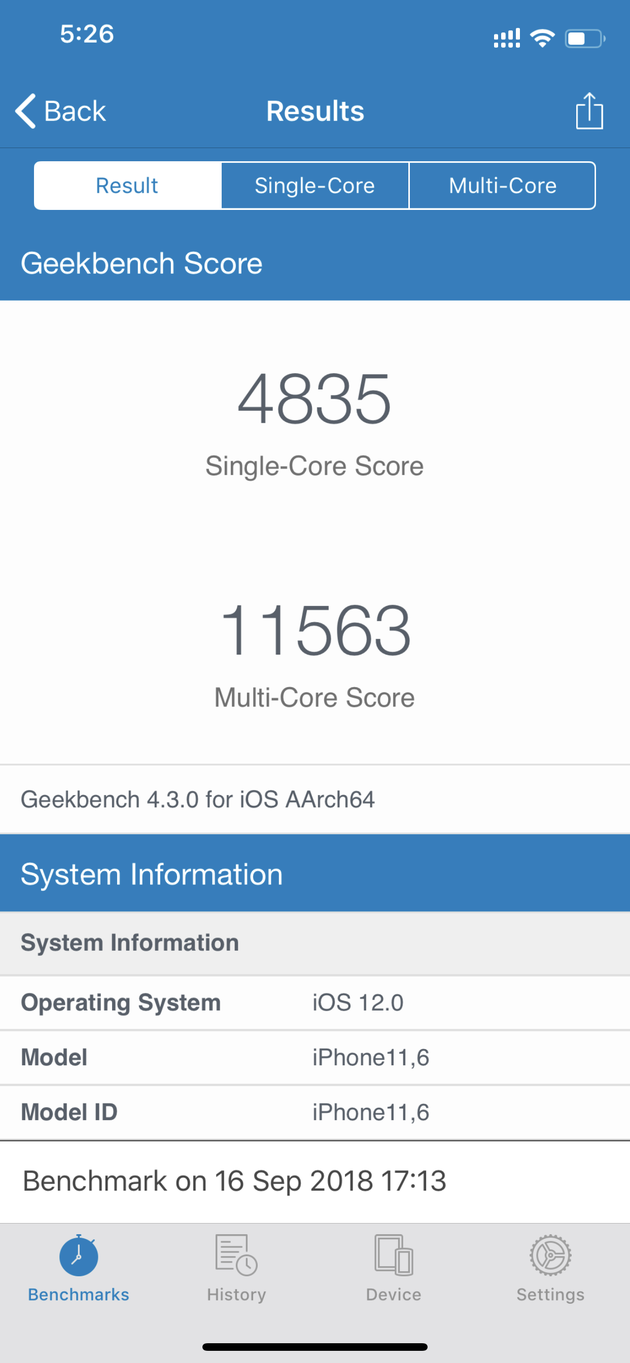

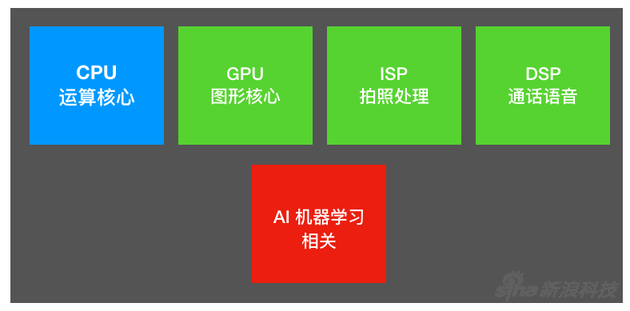

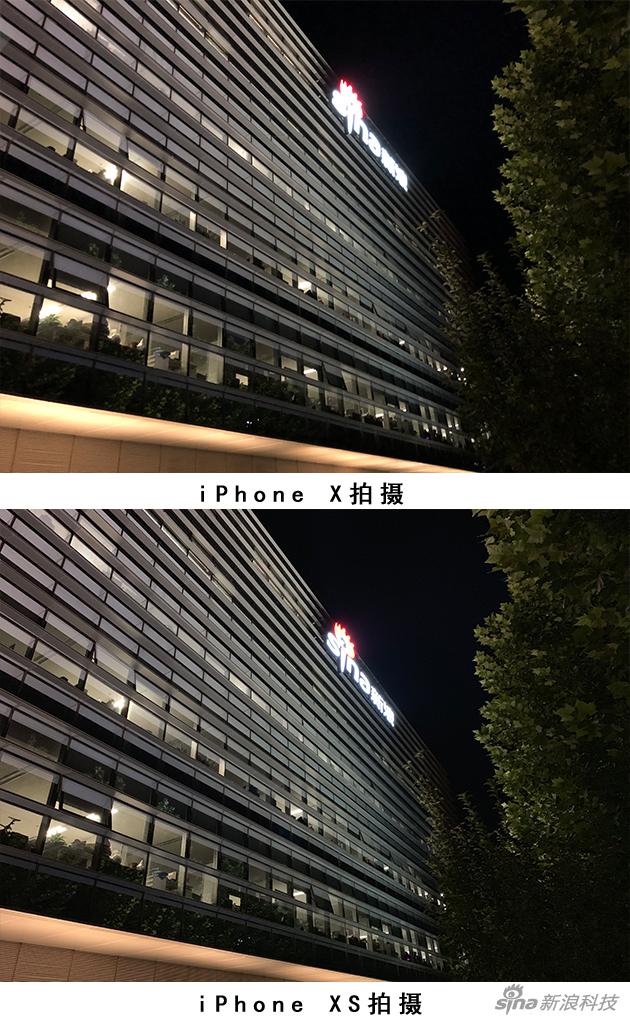

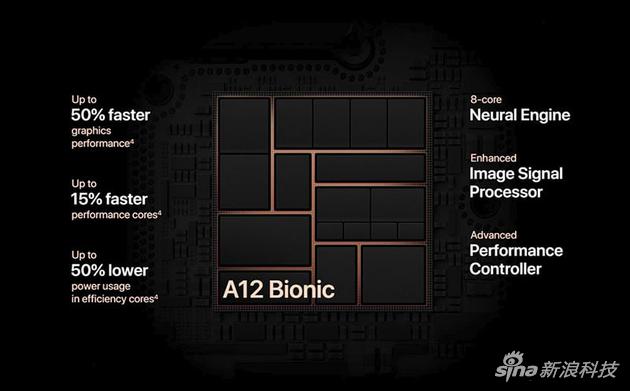

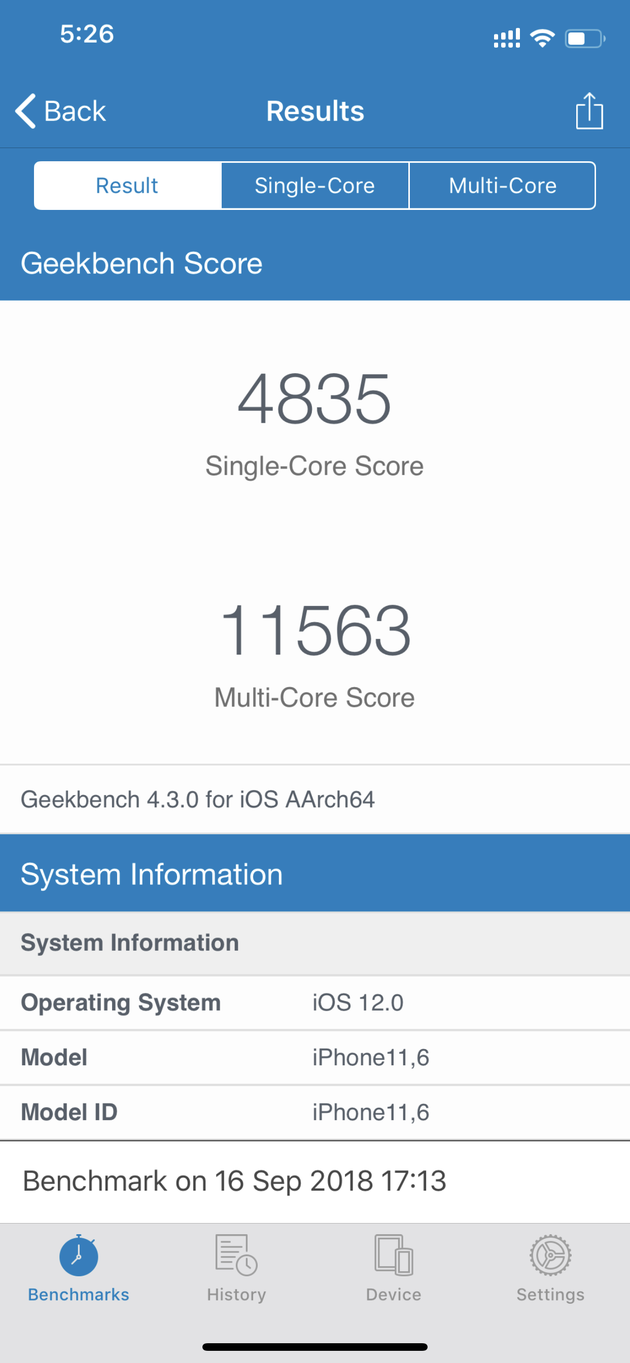

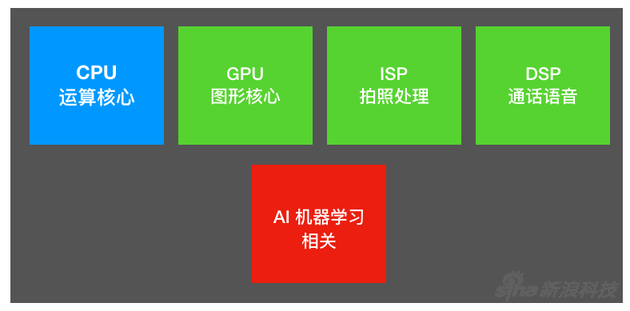

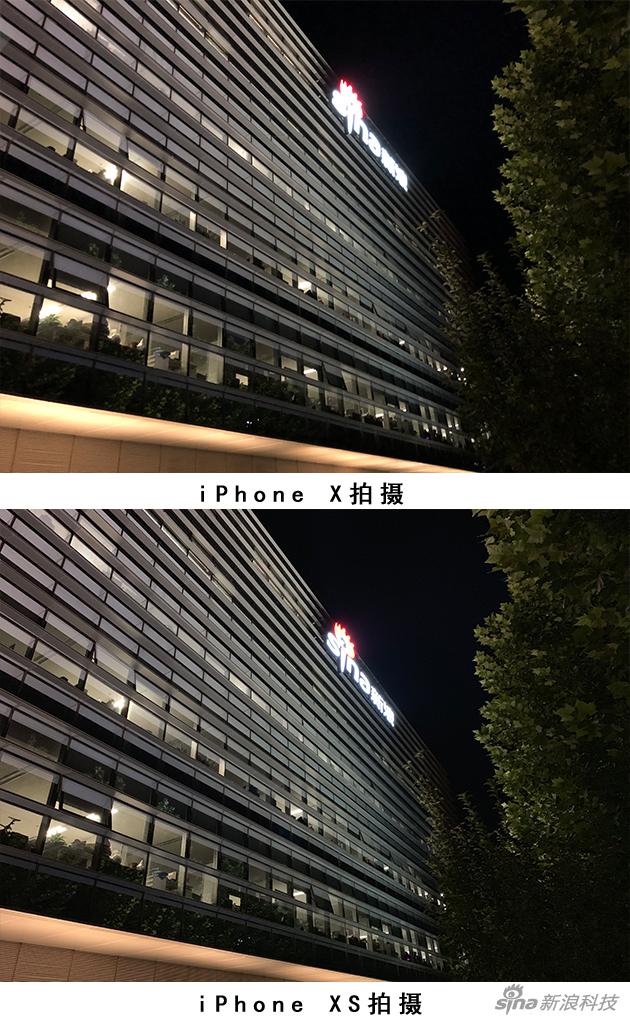

A12是全场亮点 曾有一段时间,每次A系列芯片发布都是对比上代50%以上的超越,一步步奠定了苹果A系类芯片的强悍性能和好口碑。 但最近一年,发布会不再突出陡峭的性能曲线对比,而是更多的讲起了AI人工智能。 先来说下“A12仿生芯片”的一些基本参数:集成Arm架构64位6核CPU,其中有2个大核(性能部分),4个小核(能效部分)。官方称大核比上代A11处理速度提高15%,功耗降低30%;小核比A11功耗降低50%。 值得关注的是这次GPU部分提升很多,苹果跟Imagination公司断交后,第二代自行设计的图形芯片在处理速度上比A11快了50%。 这些数据摆在一起说明,A12仿生芯片本身素质不差,尤其GPU部分。  A12仿生芯片三大特点:性能核强调功耗降低,GPU性能提升50%,以及8个神经网络核 A12仿生芯片三大特点:性能核强调功耗降低,GPU性能提升50%,以及8个神经网络核 这颗芯片是7纳米制程,共有69亿个晶体管,数字跟华为不久前在IFA上发布的麒麟980芯片一致。有人争论究竟谁是第一的问题,其实能够独立研发,证明两家厂商做的都不错,只不过华为先发布芯片,而苹果先应用到了手机上。 谈到性能,就不能免俗的先来个跑分透底: iPhone XS和XS Max都采用A12仿生芯片,4GB RAM。在25摄氏度室温下跑分结果是单核4800分/多核11500分左右。  iPhone XS系列跑分结果 iPhone XS系列跑分结果 这分数对比已经不像去年的A10(单核3300/多核5500)到A11(iPhone X,单核4200/多核10000)那种飞跃性提升,苹果今年把重点放在了AI上面。 近两年,业内几家厂商都更强调AI。一块芯片(SoC)中,不仅仅只有负责计算的CPU、负责图形的GPU、负责拍照的ISP、负责处理通话的DSP等等,还加入了负责AI神经网络的部分,华为称之为NPU,苹果称为Neural Engine(神经引擎),名字不同,功能大体一样。  一颗Soc芯片的自我修养(机器学习是最近厂商都关注的部分) 一颗Soc芯片的自我修养(机器学习是最近厂商都关注的部分) 去年的苹果A11就强调自己是“仿生芯片”,它的神经网络引擎模块是双核配置,同期麒麟970的NPU是单核;今年麒麟980的NPU为2核,苹果A12直接到了8核。 CPU和GPU部分可以跑分,但AI引擎部分目前还没有类似的考量办法。麒麟芯片用图片识别数据来考量:麒麟970每分钟能识别2005张图像、麒麟980每分钟骤增到识别4500张图像。 苹果用运算次数衡量,官方公布A12仿生芯片能够进行每秒5万亿次的运算,并且苹果宣称它已经能够进行“实时机器学习”,以此为人工智能加速。 为了能让用户直接感受到AI学习加速,发布会请来了前NBA球星纳什(Steve Nash)做演示,他介绍那款App叫《HomeCourt》,一款运用了苹果机器学习框架Core ML的应用。它教你打篮球,AI人工智能在其中充当教练。  发布会上为了表现AI实时学习能力,选了《HomeCourt》应用,并找来前NBA明星纳什(左)来讲解 发布会上为了表现AI实时学习能力,选了《HomeCourt》应用,并找来前NBA明星纳什(左)来讲解 实际功能上,《HomeCourt》利用手机镜头拍摄使用者,用户每次投篮都会被手机记录下,画面里捕捉到你的投篮动作、角度、速度等参数,之后AI教练会指导你,让一切变得更精确。 这款看似简单的App,集成了影像捕捉,动作和物体识别,动作标准度分析等等多重技术,并且都是实时的——也就是说这款App印证的正是苹果想要说的“实时AI学习过程”。 A12成了拍照的新推动力 但毕竟不是所有用户都要用手机来打篮球,实际上AI的影响已经遍布于iPhone之中,比如人们最常用的拍照。 A12对iPhone XS拍照的帮助,体现最明显的就是智能HDR和景深控制这两个方面。 HDR在如今并不是什么高级功能:同时拍多张合成,分别对应欠曝光、正常曝光和过度曝光等,然后利用多张合成,突出每张照片最好的部分,实现更广阔的光暗差(动态范围)。只是HDR需要手机芯片有较好的计算能力,在前几年手机性能不足时相对稀缺。 智能HDR原理类似,提升的是精准度,苹果切入的正是这个点,他们让一个具有八个神经引擎核心的A12芯片去介入这个过程,从而造出“智能HDR”这个功能,拍摄出具有更高动态范围和更多图像细节的照片。 我们来看下iPhone XS系列和iPhone X在同一场景下的实际对比。 首先是一组室外样张,相比较iPhone X,XS逆光处的暗部明显更亮,可辨识的内容更多;而天空云朵高光的色彩过渡也更细腻有层次。以往过曝的画面被更好的抑制了。  iPhone X和XS开启HDR室外逆光拍摄对比 iPhone X和XS开启HDR室外逆光拍摄对比 这两组对比样张都是在HDR打开的情况下拍摄,不同的是iPhone X是“自动HDR”,而iPhone XS叫“智能HDR”,新功能在面对大光照比画面时,能更好的还原暗部和高光细节。两张放一块,能看到iPhone XS拍的小悟空稍微提亮,但细节和色彩都充实许多,背景利用算法合成,云彩和楼宇质感和层次更好。  iPhone X和XS开启HDR逆光拍摄对比(对焦点均是小悟空脸部) iPhone X和XS开启HDR逆光拍摄对比(对焦点均是小悟空脸部) 说到拍照,不免还是要讲苹果在拍照上的原则:尽量保持原样。智能HDR并不等于加滤镜,不会让画面看起来太假,而很多国产厂商走的则是另一条路,让自己的照片通过自动渲染变得更悦目。 另一个关于拍照的新玩法是人像模式下景深控制。 这功能也不算新想法,“先拍照后对焦”是HTC在4年前开始做的,今年也有很多安卓厂商这么玩,但苹果做得更巧妙。景深控制的研发过程中,相关团队参考了许多相机镜头,把变焦参数变成手机算法,由此,在上一代“人像模式”的基础上,实现了可调节背景虚化效果。 这种方式既需要硬件也需要软件,算法(或者说A12的计算能力)在其中再一次占了重要角色。 依然是模特小悟空来为我们演示效果,请注意他身后变化:  人像模式加入了后期光圈调整(GIF动图) 人像模式加入了后期光圈调整(GIF动图) iPhone XS系列拍照的另一个提升是夜拍能力,今年的新手机摄像头虽然还是1200万像素,但它换了感光元件,提升了每个像素点的面积和深度,让进光量提升,以此来改善暗光环境成像效果。  夜拍图片对比 夜拍图片对比 同样拿iPhone X以及XS做对比,弱光下XS的纯净度确实有所提升,以往在夜景照片中的“朦胧感”少了,高光部细节和锐度也更高。新浪logo能看到眼睛,窗户在放大后能看到楼内的景物,而不是相连接的模糊色点。 对拍照做个总结:打个比方,如果感光元件或镜头本身是武侠小说里的外练功夫,算法和AI的加入就是内力的提升。 至于这次选择练内功,苹果有自己的历史原因:iPhone XS系列本身硬件不差,但这个机身设计,也不能再塞进更多镜头模组或感光原件了。苹果现在做的,其实就是在手机厚度有限,无法放进更大感光元件或镜头的情况下,用芯片算力提升去催动拍照的发展。A12刚好满足了这种条件,相比单纯升级硬件,未来也还有更多可能。 |

发表于 2018-9-22 03:41

|

发表于 2018-9-22 03:41

|